大一统视频编辑框架:浙大&微软推出UniEdit,无须训练、支持多种编辑场景

大一统视频编辑框架:浙大&微软推出UniEdit,无须训练、支持多种编辑场景随着 Sora 的爆火,人们看到了 AI 视频生成的巨大潜力,对这一领域的关注度也越来越高。

随着 Sora 的爆火,人们看到了 AI 视频生成的巨大潜力,对这一领域的关注度也越来越高。

北大团队联合兔展发起了一项Sora复现计划——Open Sora。

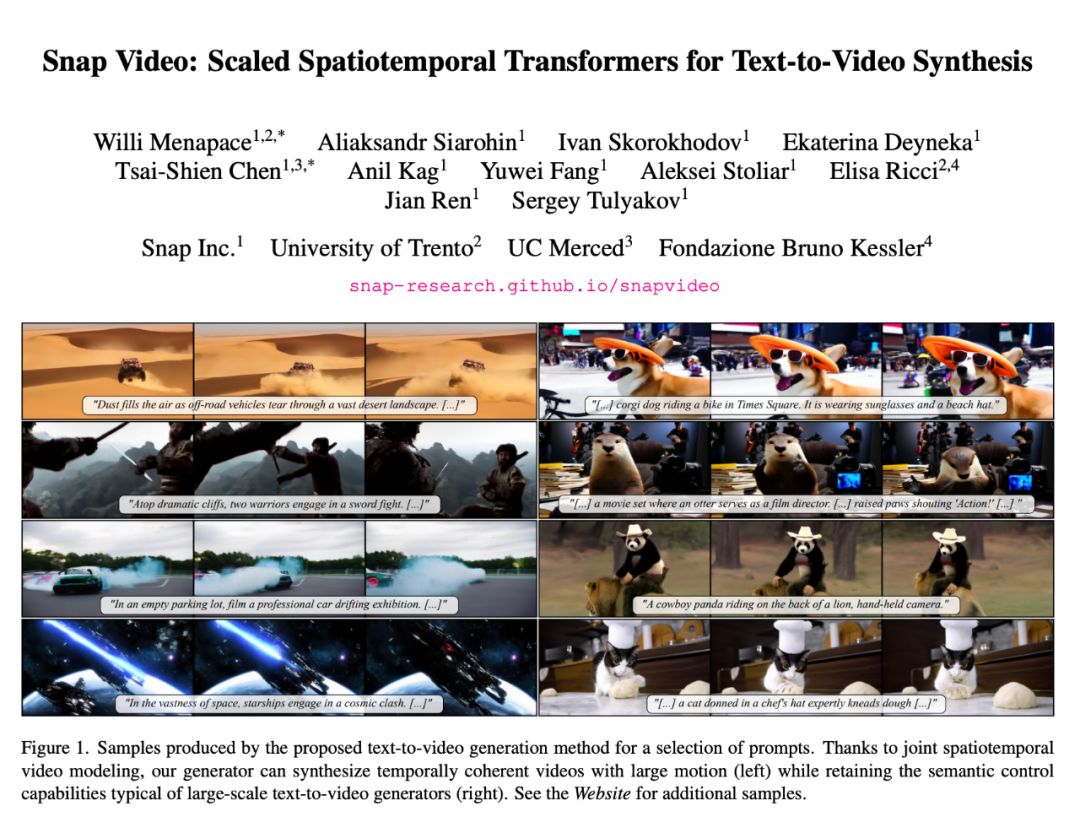

最近,OpenAI 视频生成模型 Sora 的爆火,给基于 Transformer 的扩散模型重新带来了一波热度,比如 Sora 研发负责人之一 William Peebles 与纽约大学助理教授谢赛宁去年提出的 DiT(Diffusion Transformer)。

Sora 的出现,会如何改变电子游戏开发和制作流程,带来怎么样的范式转移,也是行业关注的问题。

近期,DiT(Diffusion Transformer)论文的作者谢赛宁在朋友圈分享了他对 Sora 的看法,其中核心资源的排序是——人才第一、数据第二、算力第三,其他都没有什么是不可替代的。

2023 年年底,很多人都预测,未来一年将是视频生成快速发展的一年。但出人意料的是,农历春节刚过,OpenAI 就扔出了一个重磅炸弹 —— 能生成 1 分钟流畅、逼真视频的 Sora。

刚刚,Sora第二波视频放出了!稳定的一致性和模拟现实的逼真度,简直让人惊掉下巴。在好莱坞,已经有导演撤掉自己的8亿美元工作室扩建计划了。

2024/02/15,农历正月初六,OpenAI 发布了王炸级产品 Sora,可以通过文字描述生成长达 60s 的视频,画面非常流畅,真实度很高。一下子在国内互联网炸开了锅,得到了广泛传播。

在 OpenAI 发布 Sora 之后,很多人惊呼人类已经迈入 AI 视频时代。除了一次次震惊世界的 AI 视频生成能力展示之外,海外网友讨论的最多的话题,还有「未来该如何避免虚假视频充斥着我们的生活」?

2 月 16 日,OpenAI Sora 的发布无疑标志着视频生成领域的一次重大突破。Sora 基于 Diffusion Transformer 架构,和市面上大部分主流方法(由 2D Stable Diffusion 扩展)并不相同。